DeepSeek R1: 언어 모델 학습의 새로운 지평을 열다

DeepSeek R1, 이 모델을 처음 봤을 땐 그냥 또 하나 나왔구나 싶었어요. 그런데 자세히 들여다보니, 이건 뭔가 다르더라고요. 단순히 언어를 예쁘게 만드는 걸 넘어서, 마치 생각을 '하려는' 모델 같달까요?

DeepSeek V3를 기반으로 한 이 모델은 사람처럼 더 자연스럽게 사고하고 대답하려는 느낌이 강했어요. 마치 우리가 친구랑 대화할 때 맥락을 이해하고 말 꺼내듯이요. 그 구조도 잘 짜여 있고, 배려가 느껴진달까?

실제 환경에서도 눈에 띄는 성과

DeepSeek R1은 다양한 고난이도 데이터셋에서 뛰어난 성능을 보였습니다:

- ARC-2024: 수학과 논리 문제 위주의 복잡한 질문들.

- Codeforces 및 SW Bench Verified: 코드 생성과 관련된 평가.

- MMLU & GPQA-Diamond: 멀티태스크와 전문가 수준의 응답 능력을 평가하는 문제들.

이런 평가 기준에서 R1은 OpenAI의 Omni-1 Mini 모델과 대등하거나, 오히려 더 뛰어난 결과를 보여주기도 했습니다. 확실히 진지하게 봐야 할 신예 모델이죠.

GRPO로 더 똑똑하게 학습하다

보통 강화학습이라고 하면 뭔가 복잡하고 수학 냄새부터 나잖아요? 그런데 GRPO 방식은, 그냥 쉽게 말해서 모델이 스스로 다양한 답을 시도해보고 어떤 게 나은지 스스로 배우는 방식이었어요.

마치 시험 치고 나서 "아 이건 이게 나았겠구나" 하고 깨닫는 느낌? 덕분에 사람처럼, 정답을 알려주지 않아도 그 방향을 스스로 찾아가는 똘똘한 친구를 키우는 느낌이었죠.

한 걸음씩 사고하는 법을 가르치다

Think, 그리고 Answer. 모델이 답변을 이렇게 두 파트로 나눠서 작성하는데요. Think에서는 일단 생각을 정리하고, Answer에서 결론을 내는 식이에요.

이게 정말 신기했던 게, 저도 종종 복잡한 문제 앞에서 머릿속으로 정리하고 말하잖아요? 딱 그걸 모델이 그대로 따라하는 것 같았어요. 학습이 진행될수록 그 '생각의 길이'도 늘어나고, 정답률도 올라갔다는 거 보고 조금 감탄했죠.

감독 없이도 자연스럽게 정렬되는 학습

DeepSeek R1은 간단한 규칙 기반 보상 시스템으로 학습을 유도합니다:

- 정답을 맞췄는가?

- 지정된 형식을 잘 따랐는가?

특히 정답이 명확한 수학 문제에서는 이런 보상 시스템이 모델의 자연스러운 학습을 이끌어내는 데 효과적입니다.

더 친절한 출력으로 다가가기

예전에 챗봇들이 말은 맞는데 왠지 딱딱하고 거리감 느껴질 때 많았잖아요? DeepSeek R1은 그런 점을 개선하려고, 고급 예제 몇 개를 더 학습시켰대요.

실제로 써보면 답변이 훨씬 자연스럽고 덜 기계적이에요. 마치 "말 좀 통하네!" 싶은 그런 순간이 와요. 대화가 더 부드러워졌달까?

연산 자원을 더 영리하게 활용하기

추론할 때도 이 친구는 꽤 똑똑하게 움직입니다. 그냥 한 번 답하고 마는 게 아니라, 다양한 방식으로 여러 답을 내보고, 그중에서 가장 괜찮은 걸 골라내는 식이에요.

예전엔 이런 건 고급 옵션이었는데, 이젠 기본으로 들어가 있다는 게 놀라워요. 이 작은 디테일들이 사용자를 위한 배려로 느껴지더라고요.

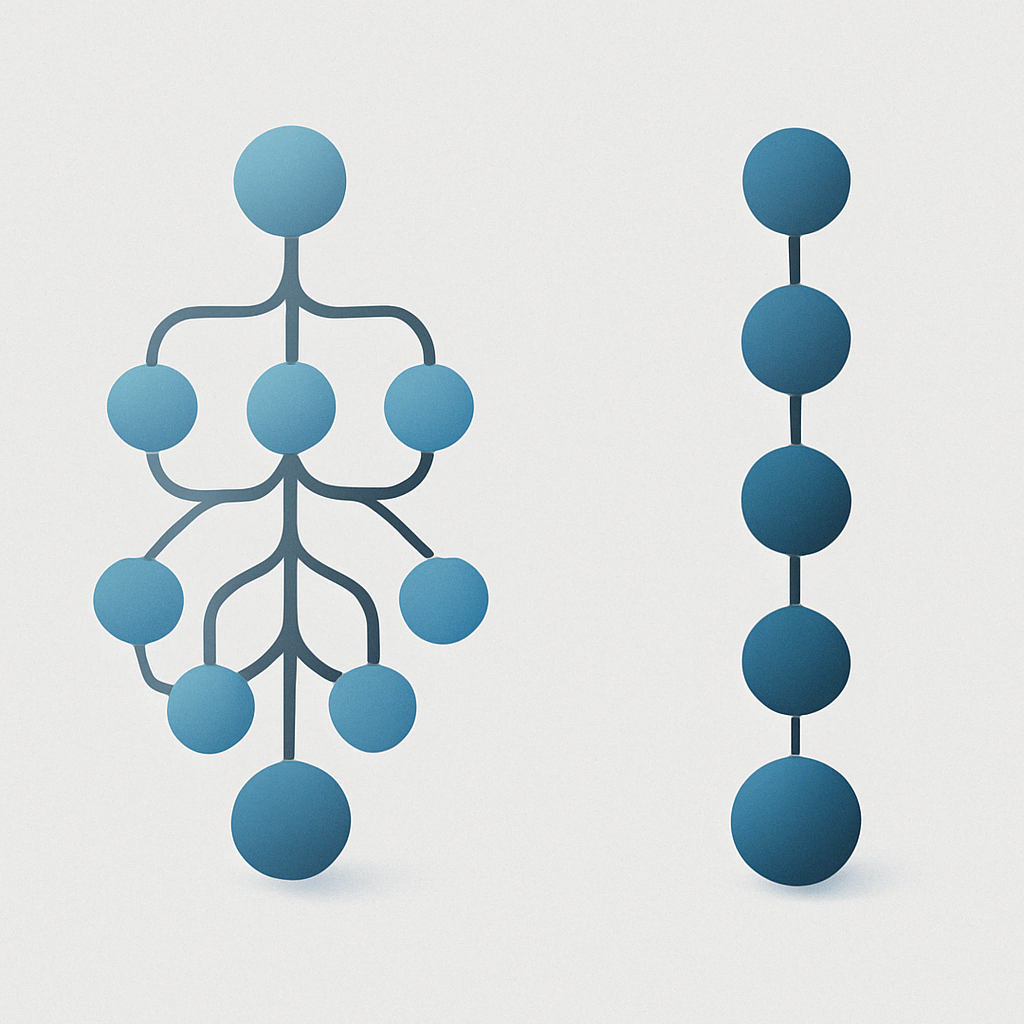

작은 모델도 크게 성장할 수 있다

DeepSeek 팀은 R1으로 만든 데이터를 작은 모델에도 전수했대요. 말하자면, 똑똑한 형이 동생 가르쳐주는 느낌이랄까요?

이게 참 좋은 게, 꼭 거대한 모델이 아니어도 괜찮은 성능을 낼 수 있다는 거예요. 컴퓨팅 자원 부족한 팀에도 희망이 되는 소식이죠.

앞으로를 위한 메시지

DeepSeek R1이 전하는 핵심은 이렇습니다:

- 명확한 과제에는 규칙 기반 보상이 효과적이다

- 모델에게 사고 방식을 가르치면 성능이 높아진다

- 추론 단계의 전략만으로도 학습을 보완할 수 있다

- 큰 모델의 지식은 작은 모델에게도 전달될 수 있다

이제 AI도 단순히 크기만 중요한 시대는 끝났어요. 얼마나 똑똑하게 설계됐는지, 얼마나 사람처럼 생각할 수 있는지가 더 중요하죠.

DeepSeek R1을 써보면, 그냥 똑똑한 기계를 넘어서 나랑 '소통'하려고 애쓰는 친구처럼 느껴져요. 이게 바로 기술이 사람에게 다가가는 방식이 아닐까요?

'SW > 인공지능' 카테고리의 다른 글

| 월 10달러로 Claude, GPT, 이미지 생성까지? ChatLLM 직접 써본 후기 (0) | 2025.06.14 |

|---|---|

| GPT처럼 이미지를 생성한다고? BAR 모델로 본 최신 AI 이미지 생성 기술 (0) | 2025.06.12 |

| OpenAI o3 Mini와 Codeex 솔직 후기: AI 개발툴 5종 비교 체험기 (Claude, Firebase Studio, Cursor까지) (0) | 2025.06.03 |

| AI 코딩툴 완전 활용법! 작업 자동화에 도움 되는 MCP 서버 8가지 (0) | 2025.05.30 |

| PLPD란? 테스트 타임 어댑테이션을 한층 더 똑똑하게 만드는 방법 (0) | 2025.05.26 |