반응형

이번 포스팅에서는 초기화에 대해 계속 이야기 할 것입니다. 고급 전략으로 Xavierinitialization이라 합니다. Xavierinitialization은 Glorot이라고도 합니다. Glorot 또는 Xavier는 2010년에 이 방법을 제안하고 대규모로 빠르게 채택되었으므로 좋은 기술이라 할 수 있습니다.

처음 배운 방법은 임의로 선택하는 방법이었습니다. 균일하고 일반적인 Xavier 초기화는 모두 기본입니다. 랜덤화에 사용되는 방법은 중요하지 않습니다. 각 레이어의 통과와 함께 다음과 같은 경우 아웃풋 수입니다.

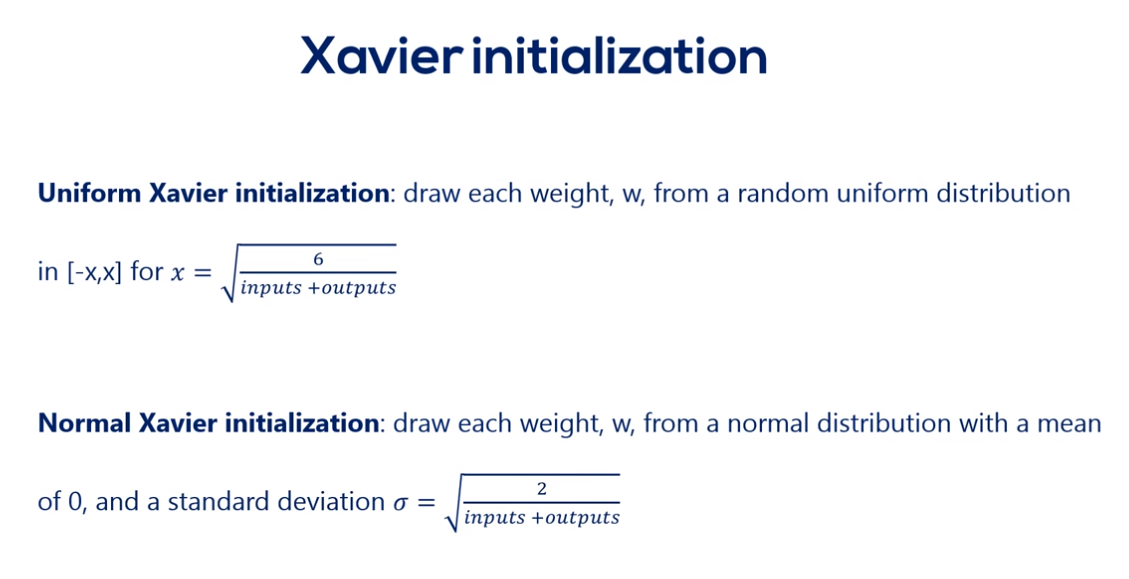

초기화는 일부 범위에서 분산을 유지합니다. 두 가지 공식이 있습니다. Uniform Xavier Initialization입니다. -x, x까지의 무작위 균일 분포에서 각 가중치 W를 그려야합니다.

정규화 실행을 위해 평균 0과 표준 편차 2를 인풋과 아웃풋으로 나눈 값으로 정규 분포에서 각 가중치 W를 그립니다. 그러나 아이디어는 동일합니다. 또 다른 세부 사항은 인풋 및 아웃풋이 명확하다는 것입니다.

활성화 함수는 진행되는 위치입니다. 가중치를 더 많이 분산시켜야 할 필요는 엇습니다. 역전파를 통해 이루어집니다. 가중치를 더 많이 분산시켜야 할 필요는 없습니다. 역전파를 통해 이루어지므로 역전파를 할 때 분명히 같은 문제가 있습니다. 따라서 변수의 초기화를 자동으로 채택하는 방법을 지정하지 않고 변수를 초기화합니다.

반응형

'SW > 딥러닝' 카테고리의 다른 글

| 31. 딥러닝 : 경사 하강 함정 (gradient descent pitfalls) : 원인, 이유, 배경 (0) | 2020.03.25 |

|---|---|

| 30. 딥러닝 : 확률적 경사 하강 : 개념, 원리, 장점, 사용 이유 (0) | 2020.03.24 |

| 28. 딥러닝 : 단순 초기화의 타입 : 초기화 유형, 방법, 개념, 유념 (0) | 2020.03.22 |

| 27. 딥러닝 : 오버피팅(과적합) : 훈련 멈추는 시점, 팁, 개념, 종류 (0) | 2020.03.14 |

| 26. 딥러닝 : K-FOLD CROSS-VALIDATION (K배 교차 검증) : 개념, 방법, 팁 (0) | 2020.03.13 |