조금 과감하게 말해보자면, LAPA는 ‘로봇 학습의 출발선’을 다시 그려버린 접근이다. 실제 로봇에서 수집한 action label 없이도, 인터넷에 널린 방대한 비디오 데이터만으로 로봇 foundation model을 Pretraining할 수 있다는 점에서다. 그 결과는 꽤 인상적이다. 기존 VLA 계열 모델 대비 평균 6.2% 높은 성능, 그리고 Pretraining 효율은 무려 30배 이상.

핵심은 단순하다. LAPA는 Ground Truth action에 기대지 않는다. 그래서 특정 로봇, 특정 데이터셋에 과도하게 맞춰지는(overfitting) 문제를 피하고, Cross-embodiment 환경에서도 surprisingly 안정적인 성능을 보여준다.

무엇보다 흥미로운 대목은, 사람이 물건을 다루는 장면—즉 Human Manipulation Video—만으로도 로봇을 학습시킬 수 있다는 가능성을 실험으로 증명했다는 점이다. 로봇 데이터를 직접 모으는 데 드는 시간과 비용을 생각하면, 이건 꽤 큰 방향 전환이다.

VLA 모델, 어디까지 왔고 무엇이 막혔을까

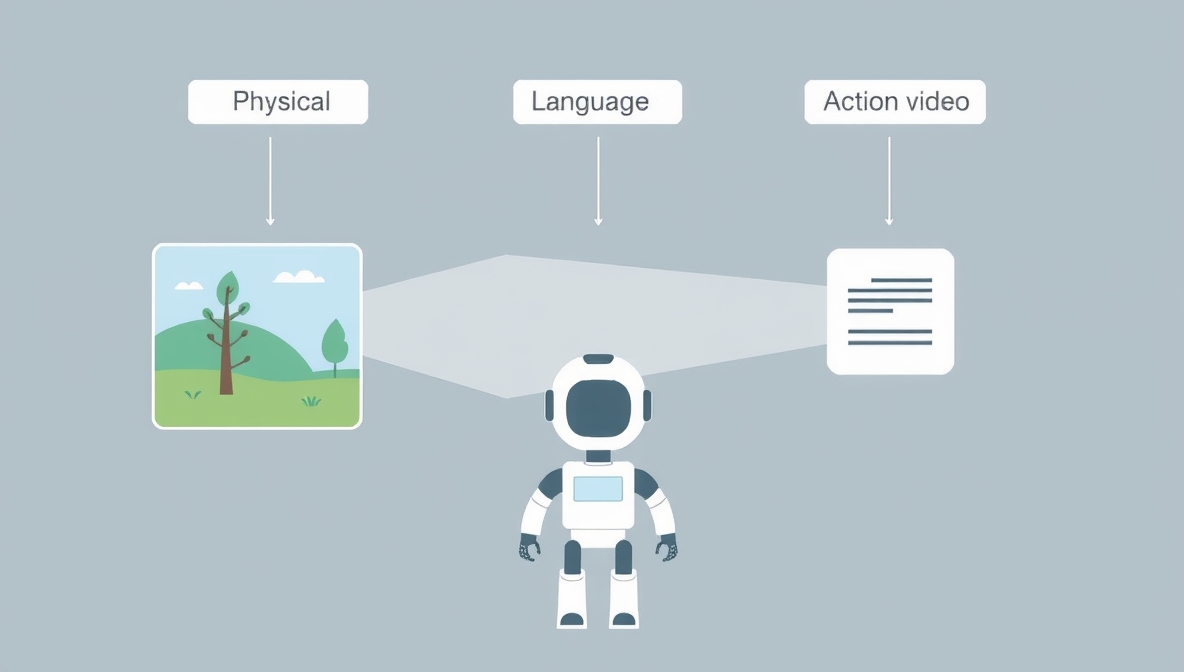

요즘 로보틱스에서 VLA(Vision Language Action) 모델은 거의 표준처럼 쓰인다. Vision Encoder로 장면을 이해하고, LLM으로 언어 instruction을 해석한 다음, 이 둘을 정렬(alignment)해 로봇 action을 예측하는 구조다. 새로운 명령에도 비교적 잘 대응하고, 처음 보는 object나 환경 변화에도 어느 정도 버텨준다.

문제는 데이터다. 대부분의 실제 로봇 데이터셋은 사람이 직접 로봇을 조작해가며 수집해야 한다. 시간도 많이 들고, 규모를 키우는 데 한계가 있다. 그래서 자연스럽게 떠오른 대안이 YouTube 같은 웹 비디오였다.

하지만 여기엔 두 개의 큰 벽이 있다. 첫째, 명시적인 action label이 없다. 둘째, 사람의 행동과 로봇의 action 사이에는 구조적인 분포 차이가 존재한다. 그냥 가져다 쓰기엔 간극이 너무 컸다.

LAPA라는 발상의 전환

LAPA는 이 문제를 정면으로 비튼다. ‘그럼 action label 없이도 학습할 수 없을까?’라는 질문에서 출발한다. 그리고 그 답으로, 완전히 비지도 방식의 Pretraining 파이프라인을 제안한다.

구조는 세 단계다.

- Latent Action Quantization

- Latent Pretraining

- Action Finetuning

이 중 앞의 두 단계에서는 Ground Truth action이 전혀 필요 없다. 이게 LAPA의 핵심 철학이다.

1단계: Latent Action Quantization — 행동을 직접 말하지 말고, 암시하자

첫 번째 모델은 Encoder–Decoder 구조를 가진 Latent Action Quantization Model이다. 여기서의 목표는 명확하다. ‘지금 프레임 xt에서 미래 프레임 xt+h로 가기 위해 필요한 변화’를 Latent Action zt로 압축해내는 것.

Encoder는 현재 프레임과 미래 프레임을 함께 받아 Spatial Transformer와 Temporal Transformer를 거쳐 Latent representation을 만든다. 흥미로운 부분은 여기서 시간 차이를 단순히 이어붙이지 않고, E2 − E1 형태로 말 그대로 ‘변화량’을 계산한다는 점이다.

이 변화량은 Codebook을 통해 이산화된다. VQVAE 스타일로, 가장 가까운 vector를 찾아 Discrete Latent Action으로 바꾸는 방식이다. Codebook은 일종의 ‘행동 사전’처럼 작동한다.

Decoder는 이 Latent Action과 현재 프레임을 입력으로 받아 미래 프레임을 재구성한다. 이때 NSVQ(Noise Substitution Vector Quantization)를 사용해 Gradient collapse를 피한다. 약간의 노이즈를 섞어, Codebook 전체가 고르게 학습되도록 유도하는 장치다.

2단계: Latent Pretraining — 비디오를 action label처럼 쓰는 법

두 번째 단계에서는 앞서 학습한 Encoder를 Inverse Dynamic Model처럼 활용한다. 즉, 비디오 클립에서 자동으로 Latent Action label을 생성하는 셈이다.

이제 VLM이 등장한다. 기존 Language Model head 대신, Latent Action head(단일 MLP)를 붙인다. Vision Encoder는 고정하고, Language Model만 학습하는 구조로 효율성을 챙긴다. Vision과 Language 간 상호작용은 Cross-Attention으로 처리한다.

여기서 중요한 포인트 하나. 이 과정은 실제 로봇 action을 전혀 보지 않는다. 언어 instruction이 붙어 있는 어떤 raw video든 학습에 쓸 수 있다. LAPA가 웹 스케일 데이터에 열려 있는 이유다.

또 하나의 장점은, action hierarchy 같은 사전 지식이 필요 없다는 점이다. 모델이 스스로 연속된 관찰을 가장 잘 설명하는 Latent Action space를 End-to-End로 만들어간다.

3단계: Action Finetuning — 현실 세계와 연결하기

물론 Latent Action은 그대로 로봇이 실행할 수 있는 action은 아니다. 그래서 마지막 단계에서 소량의 Ground Truth action 데이터로 Finetuning을 진행한다.

여기서도 전략은 동일하다. Vision Encoder는 고정, Language Model은 학습 가능 상태. Latent Action을 실제 로봇 action으로 매핑하는 데 집중한다. 데이터가 많지 않아도 되는 이유다.

실험 결과: 숫자가 말해주는 것들

LAPA는 두 개의 시뮬레이션 환경(Language Table, Simpler)과 세 가지 실제 로봇 태스크, 총 아홉 개 태스크 카테고리에서 평가됐다.

Baseline으로는 Scratch, UniPi, VPT, Action VLA, 그리고 SOTA로 알려진 OpenVLA가 사용됐다. Action VLA는 Ground Truth action을 사용하므로 사실상 Upper Bound에 가깝다.

Language Table 환경에서 LAPA는 action label 없이 Pretraining했음에도 Scratch를 크게 앞섰고, Action VLA와도 근소한 차이만 보였다. Cross-task, Cross-environment 평가에서도 일관되게 좋은 전이 성능을 보여줬다.

Simpler 환경에서는 더 흥미로운 결과가 나온다. Diffusion 기반 UniPi 모델은 action label이 줄어들자 성능이 급격히 떨어진 반면, LAPA는 비교적 안정적인 성능을 유지했다.

특히 Multi-embodiment 세팅에서는, Ground Truth action으로 학습된 OpenVLA를 평균적으로 능가했다. 특정 action space에 과적합되지 않았다는 점이 여기서 강점으로 작용했다.

Human Manipulation Video의 잠재력

가장 인상적인 실험은 인간 조작 비디오를 대규모로 확장했을 때다. 시뮬레이터와 실제 로봇 환경 모두에서, LAPA는 Scratch는 물론 Bridge EV 데이터셋으로 학습된 OpenVLA보다도 평균적으로 더 나은 성능을 기록했다.

이건 단순한 성능 비교를 넘어선다. ‘로봇 데이터를 직접 모으지 않아도 된다’는 가능성을, 꽤 설득력 있게 보여줬기 때문이다.

정리하며: 가능성과 남은 숙제

LAPA는 Ground Truth action 없이 VLA를 Pretraining할 수 있음을 실험적으로 증명했다. 97만 개 action label로 학습된 OpenVLA보다도 높은 성능을 보였고, 학습 시간은 30~40배 더 효율적이었다.

물론 한계도 있다. Grasp처럼 미세한 동작에서는 아직 부족하다. Latent Action space를 더 세분화하면 개선 여지가 있어 보인다. 또한 실시간 추론 시 latency 문제도 남아 있다. Hierarchical architecture가 하나의 해법이 될 수 있을 것이다.

그럼에도 불구하고, LAPA가 던진 메시지는 분명하다. 로봇 학습은 더 이상 로봇 데이터에만 묶여 있을 필요가 없다는 것. 인터넷에 이미 쌓여 있는 수많은 비디오가, 이제는 로봇에게도 교과서가 될 수 있다.

'SW > 인공지능' 카테고리의 다른 글

| NVIDIA GR00T란 무엇인가? 휴머노이드 로봇을 위한 파운데이션 모델 완전 정리 (2025) (0) | 2026.02.02 |

|---|---|

| Cursor 2.0 완벽 가이드: AI agent 기반 code editor를 처음 쓰는 개발자를 위한 설명 (0) | 2026.01.30 |

| parallel scaling이란? LLM 성능을 키우는 새로운 방법을 쉽게 설명 (0) | 2026.01.29 |

| 2026년 기준 LLM 로컬 실행 방법 정리: Ollama와 Docker Model Runner 비교 (0) | 2026.01.28 |

| 2025년 AI website builder로 웹 개발 에이전시 시작하는 방법 (white label 모델 정리) (0) | 2026.01.25 |